バギング【bagging】bootstrap aggregating

概要

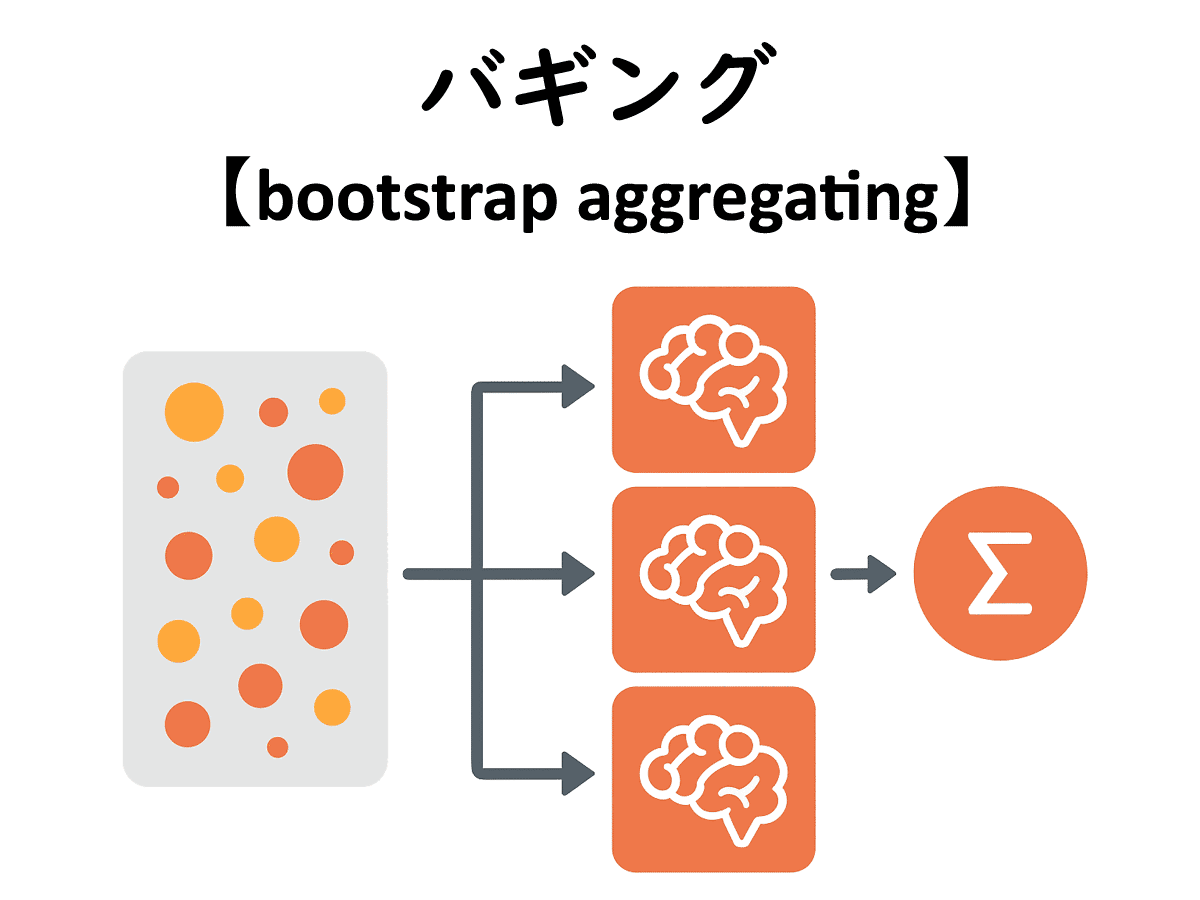

アンサンブル学習は機械学習の精度や安定性を向上させるテクニックの一つで、方式や教師データの異なる複数のモデルを作って組み合わせる。バギングでは同じ手法で異なるデータを学習した複数のモデルを作り、結果を総合して最終的な出力とする。

バギングではまず、教師データからランダムにデータを抽出し、小さなデータセットを複数作成する。このとき、同じセットに同じデータが複数回現れることも許容する。この抽出法を「ブートストラップサンプリング」(ブートストラップ法)という。

次に、同じ機械学習システムにそれぞれのデータセットを与え、複数のモデルを作成する。予測をさせる際には未知のデータをそれぞれのモデルに与え、得られた結果を多数決(分類問題)あるいは平均(回帰問題)することによって、最終的な結果とする。

1994年にアメリカの統計学者レオ・ブライマン(Leo Breiman)氏によって考案された手法である。複数のデータセットに分けて多数決を取ることで、教師データに含まれるノイズによる結果のばらつき(バリアンス)を抑える効果があり、過学習を抑制することもできる。様々な学習手法に適用可能だが、決定木と組み合わせた「ランダムフォレスト」が特によく知られる。

(2025.9.21更新)