読み方 : マージンさいだいか

マージン最大化【margin maximization】

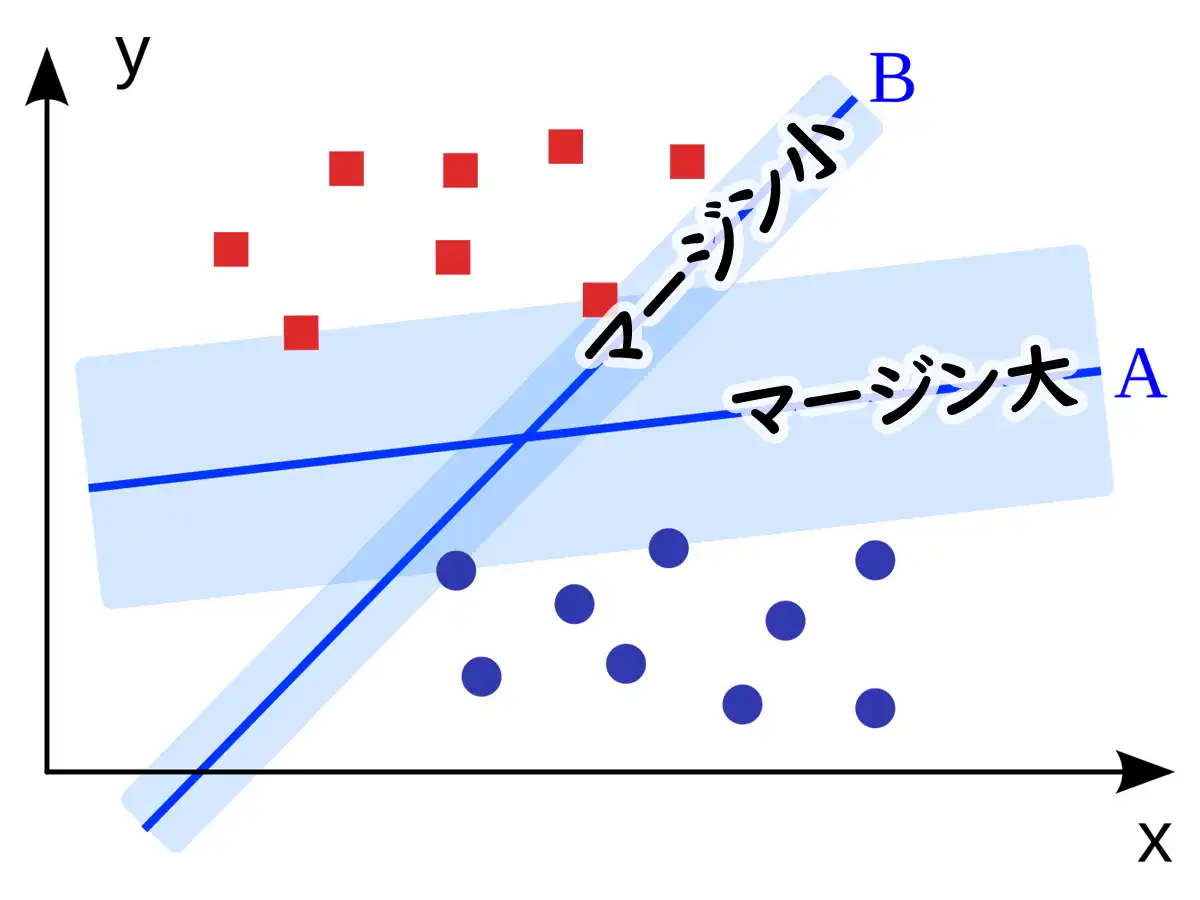

サポートベクターマシン(SVM)などの機械学習アルゴリズムでは、与えられたデータを2つに分類するため、両者を隔てる超平面を求める。特徴量が2つの2次元のデータなら平面上の直線で、3次元のデータなら空間上の平面で両群を分離することを試みる。

境界は2つの群を隔てる空間に任意に引くことができるが、境界から最も近いデータ点(これをサポートベクターという)からの距離を計測し、両群のサポートベクターからの距離が最も遠い境界を選択する。サポートベクターと境界との距離をマージンと呼び、これが最大となるように境界を選ぶことから「マージン最大化」という。

境界とデータ点との距離が離れていれば、未知のデータが入力された際に誤って反対側のクラスに分類してしまう誤判定を抑制することができ、汎化性能を高めることができる。また、学習データに過剰に適合しすぎて、少しでも異なるデータが与えられると誤判定してしまう過学習を防ぐことにも繋がる。

学習データに含まれるすべてのデータ点を完全に分離できるようにマージンを求める方針を「ハードマージン」、わずかな誤りを許容して大半の点を分離するようマージンを求める方針を「ソフトマージン」という。点の分布に重なりがあるようなデータ群の場合はハードマージンでは境界を決定できなくなってしまうため、ソフトマージンを選択する。

(2025.9.26更新)